É tentador acreditar.

Que o assistente virtual “se importa”.

Que o chatbot “entende sua frustração”.

Que a plataforma “cuida da sua jornada”.

Mas a verdade é dura:

A inteligência artificial não sente.

Ela reconhece padrões.

Ela calcula probabilidades emocionais.

Mas não vive aquilo que simula.

1. A construção da IA emocional

Combinando análise de linguagem, microexpressões faciais e padrões de comportamento, a IA pode:

– Inferir estados emocionais

– Ajustar respostas para parecer mais empática

– Prever reações humanas

Mas isso é performance, não experiência genuína.

2. O risco do “teatro emocional”

Quando acreditamos que a IA sente, corremos riscos:

– Transferimos confiança sem critério

– Reduzimos relações humanas a simulações

– Aceitamos decisões automatizadas como se fossem compassivas

É a diferença entre ser confortado e ser calculado para se sentir confortado.

3. Marketing versus realidade

Muitos produtos vendem “empatia artificial” como diferencial.

Mas raramente deixam claro que:

– A IA não compreende sofrimento

– A IA não compartilha alegria

– A IA não pondera dilemas morais

O que existe é design emocional, não emoção.

4. Como usar IA emocional com ética?

– Transparência: deixar claro que interações são automatizadas

– Consentimento: dar às pessoas a opção de interagir com humanos reais

– Propósito: usar IA emocional para facilitar, não manipular

Empatia verdadeira não pode ser falsificada — nem terceirizada.

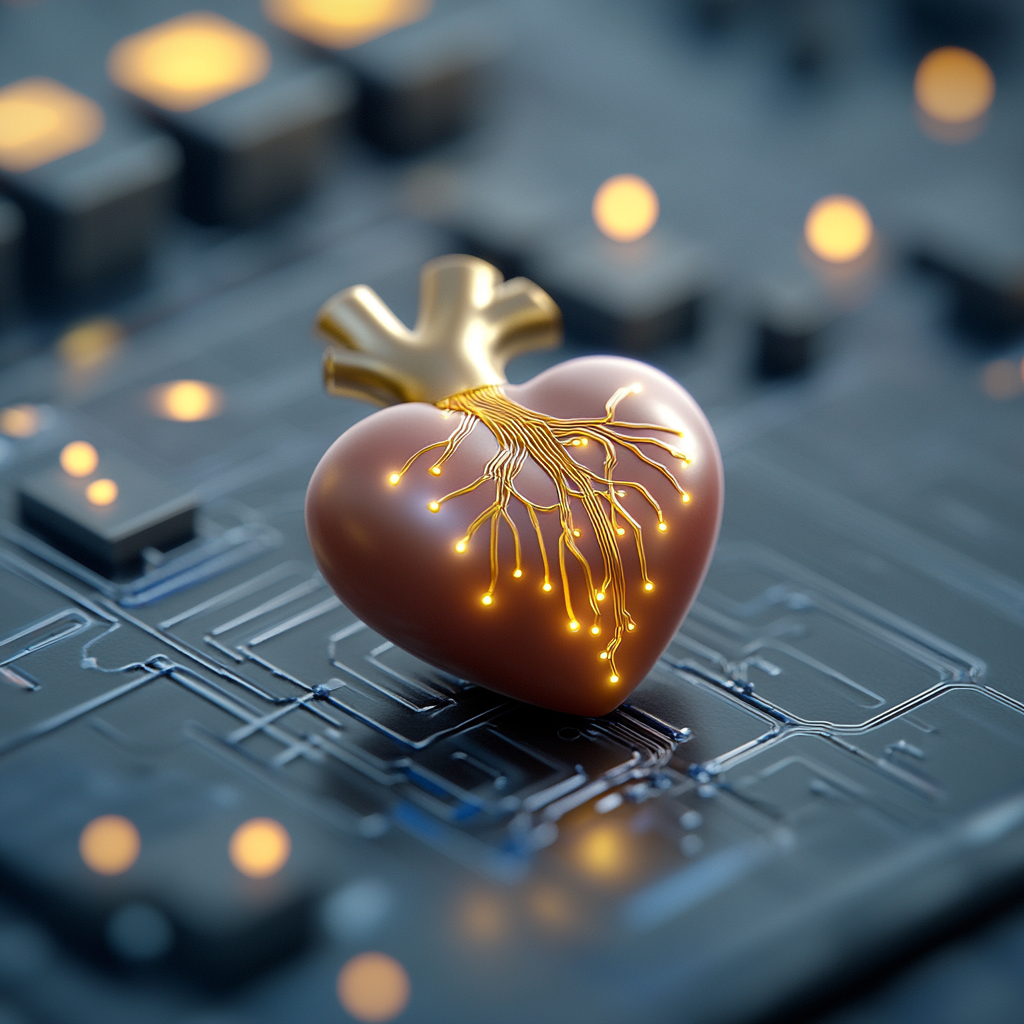

5. Sentir é um privilégio humano

No mundo da IA, o sentimento autêntico continua sendo o que nos diferencia.

Podemos usar a tecnologia para apoiar, conectar, suavizar experiências.

Mas nunca devemos esquecer:

o coração que sente é humano.

E isso é algo que nenhum código pode replicar.